Globalne trendy

Wzrost zapotrzebowania na usługi sieciowe jest efektem rozwoju społeczeństwa w dobie cyfryzacji, a także wyzwań strukturalnych stojących przed społeczeństwem cyfrowym.

Gigantyczny wzrost ruchu cyfrowego (informacyjnego) w Internecie jest niezaprzeczalnym faktem. Raport opracowany w 1994 r. przez Komisję Bangemanna pt. "Europa a globalne społeczeństwo informacyjne. Zalecenia dla Komisji Europejskiej" prognozował, że: "…kraje, które pierwsze wejdą w erę społeczeństwa informacyjnego będą rozwijać się najszybciej. To one wyznaczą drogę dla innych. Natomiast te kraje, które będą zwlekać, lub podejmą działania połowiczne, mogą w czasie krótszym od dziesięciolecia stanąć w obliczu załamania się inwestycji i kryzysu na rynku pracy". Prognozowane w raporcie zmiany właśnie dzieją się wokół nas a skala oraz proces zmian z roku na rok przyspieszają.

Kiedy społeczeństwo można nazwać „społeczeństwem cyfrowym”? Odpowiedź nie jest prosta, lecz można założyć, że linią graniczną jest osiągnięcie stopnia rozwoju procesów społecznych i gospodarczych wymuszających powszechne zastosowanie technik gromadzenia, przetwarzania, przekazywania i użytkowania olbrzymiej masy informacji generowanej przez owe procesy, a znaczna część dochodu narodowego brutto jest generowana dzięki zastosowaniu procesów informatycznych. W dzisiejszym świecie szybkość i ilość przetwarzania informacji są kluczowe dla osiągania wydajności i konkurencyjności, a także warunkują rozwój społeczny i przyrost zatrudnienia wpływając na zmianę formy organizacji pracy i wzory życia społecznego. Można zaryzykować twierdzenie, że wiele społeczeństw na świecie stały się już w znacznym stopniu „cyfrowe”.

Zauważalnie z roku na rok rośnie liczba użytkowników Internetu korzystających z coraz większej ilości usług biznesowych lub usług on-line, w tym cyfrowej administracji publicznej a produkcja i dystrybucja wszelkich produktów ściśle zależy od automatyzacji i informatyzacji. W roku 2014 ilość danych w ruchu cyfrowym rejestrowane przez dwa dowolne kolejne dni można było przyrównać z całym dorobkiem informacyjnym naszej cywilizacji wygenerowanym od jej początków do roku 2003 włącznie. Do roku 2020 ilość danych zgromadzonych przez ludzkość wzrośnie 10 krotnie i osiągnie niewyobrażalną wielkość około 44 ZB (1 ZB = 1021 bitów = 1 trylion gigabitów). Co ważniejsze, nastąpi wzrost użytecznych danych (takich, które są oznaczone i analizowane) z obecnych 22% do 35% w roku 2020. Nie tylko my się zmieniamy jako społeczeństwo. Dla wielu firm, to my staliśmy się obiektami generującymi dane do analizy zachowań jako jednostki społeczności oraz jako konsumenci.

Żyjemy w erze „BIG DATA”. Stale rośnie wielkość ruchu informatycznego w warstwie fizycznej i aplikacyjnej Internetu oraz masowo rośnie ilość rejestrowanych danych, przepustowości oraz moc obliczeniowa serwerów zarówno „własnych” dowolnego przedsiębiorstwa czy też kolokowanych w serwerowniach kolokacyjnych jak i w tzw. „chmurze”. Obecnie zarejestrowanych jest już ponad 2 miliardy użytkowników Internetu, ponad 21 miliardów urządzeń sieciowych, które dla zobrazowania samej skali obciążenia sieci, rejestrują ponad 1.3 milionów strumieni video na minutę. Należy również zauważyć ciągły wyścig technologiczny, jako że aplikacje wymagają coraz większej przepustowości, co jest związane z nowymi rodzajami usług (HDV-3D, gry on-line, Video-Calls, analiza obrazu, analiza głosu, itp.) oraz stale zwiększa się ilość urządzeń „smart” korzystających z zasobów Internetu on-line do rozrywki, zakupów, lokalizacji, rezerwacji, poczty…... Obserwuje się także stały wzrost ruchu cyfrowego związanego z tzw. Internetem rzeczy (IoT). Dla przykładu, średnio, godzina lotu samolotu pasażerskiego generuje 40TB danych / lot / godzinę.

Żyjemy w erze „BIG DATA”. Stale rośnie wielkość ruchu informatycznego w warstwie fizycznej i aplikacyjnej Internetu oraz masowo rośnie ilość rejestrowanych danych, przepustowości oraz moc obliczeniowa serwerów zarówno „własnych” dowolnego przedsiębiorstwa czy też kolokowanych w serwerowniach kolokacyjnych jak i w tzw. „chmurze”. Obecnie zarejestrowanych jest już ponad 2 miliardy użytkowników Internetu, ponad 21 miliardów urządzeń sieciowych, które dla zobrazowania samej skali obciążenia sieci, rejestrują ponad 1.3 milionów strumieni video na minutę. Należy również zauważyć ciągły wyścig technologiczny, jako że aplikacje wymagają coraz większej przepustowości, co jest związane z nowymi rodzajami usług (HDV-3D, gry on-line, Video-Calls, analiza obrazu, analiza głosu, itp.) oraz stale zwiększa się ilość urządzeń „smart” korzystających z zasobów Internetu on-line do rozrywki, zakupów, lokalizacji, rezerwacji, poczty…... Obserwuje się także stały wzrost ruchu cyfrowego związanego z tzw. Internetem rzeczy (IoT). Dla przykładu, średnio, godzina lotu samolotu pasażerskiego generuje 40TB danych / lot / godzinę.

Ten ruch w warstwie fizycznej jest obsługiwany w wielu węzłach, lecz na końcu każdego z nich znajduje się „serwerownia”.

W najbliższych latach (2016-2020) prognozuje się, że światowy rynek Data Center będzie rósł średnio w tempie 19.03% (CAGR).

Co to jest – Centrum Przetwarzania Danych

Ścisłą definicję Centrum Przetwarzania Danych podaje norma PN-EN 50600-1 (pkt.3.1.9) - „Budowla lub zespół budowli przeznaczone do zgrupowania pomieszczeń, połączeń i obsługi urządzeń techniki informacyjnej oraz sprzętu sieci telekomunikacyjnych zapewniających usługi przechowywania, przetwarzania i dostarczania danych wraz z pełnym wyposażeniem i infrastrukturą do dystrybucji energii i zapewnienia parametrów środowiskowych oraz koniecznego poziomu odporności i zabezpieczeń wymaganych w celu zapewnienia pożądanej dostępności usług”.

W języku potocznym w miejsce przyjętego w normie PN-EN 50600-1 pojęcia „Centrum Przetwarzania Danych” używane są bardzo często zamiennie pojęcia „Data Center” i „serwerownia”.

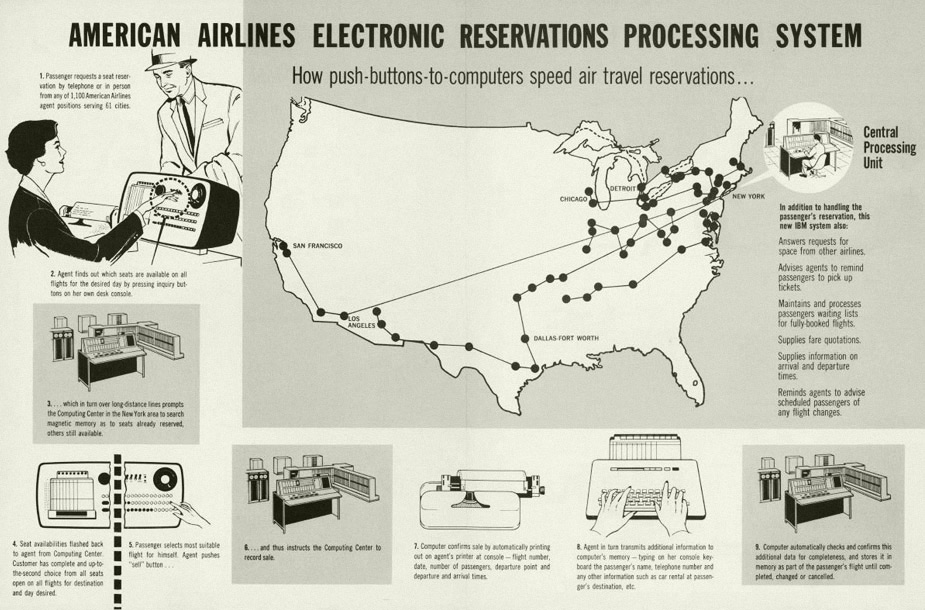

Pojęcie "serwerownia" powstało w końcu lat 50-tych, podczas wspólnej realizacji projektu American Airlines i IBM nawiązały współpracę dla stworzenia systemu rezerwacji miejsc w oparciu o rozwiązanie informatyczne firmy Sabre. Od tego czasu, zmiany strukturalne wykorzystania informatyzacji oraz możliwości technologiczne w dziedzinie przetwarzania i przechowywania danych doprowadziły do rozwiązań, które z jednej strony nadążają za zwiększającymi się wymaganiami użytkowników z drugiej generują coraz to większe możliwości związane tymi usługami np. na urządzeniach mobilnych.

Należy zauważyć, że w tym roku mija właśnie 70 lat od budowy pierwszego komputera - Electronic Numerical Integrator and Computer (ENIAC), który w 1946 roku służył „US Army” do przechowywania kodów artyleryjskich. Dzisiejsze serwerownie są w większości projekcją wymagań modelu usług w którym obserwujemy przesunięcia z modelu „własności infrastruktury”, na którą składają się: sprzęt i oprogramowanie, instalacje techniczne (zasilanie i chłodzenie) w stronę subskrypcji pojemności i mocy obliczeniowej dla dostępu do oczekiwanych przez biznes i konsumenta usług. Korzystający z zasobów Internetu przeważnie nie interesują się skąd pobierają dane, podobnie jak niewiele osób zwraca uwagę, że za gniazdkiem elektrycznym jest schowana elektrownia, a czasami także i kopalnia węgla.

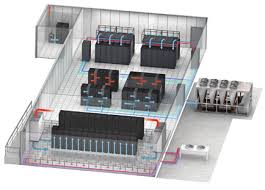

Jak zbudowana jest tradycyjna serwerownia? Jest ona budynkiem lub jego częścią, na którą składa się komora serwerów, w której instalowany jest sprzęt IT oraz pomieszczenia i obszary wspierające jej funkcjonalność, w tym pomieszczenia np.: UPS, dystrybucji energii, techniczne, telekomunikacyjne, operacyjne, pomieszczenia dystrybucji chłodu oraz obszary posadowienia agregatów prądotwórczych, agregaty chłodu, zbiorniki paliwa, itp. Wszystkie te urządzenia / systemy techniczne zwane infrastrukturą dzieli się na infrastrukturę informatyczną oraz infrastrukturę techniczną.

Na Infrastrukturę Informatyczną składają się wszystkie urządzenia systemów komputerowych, w tym urządzenia aktywne i pasywne sieciowe, serwery i pamięci masowe, wraz z okablowaniem logicznym miedzianym i światłowodowym, przyłączami telekomunikacyjnymi, której działanie jest niezbędne do osiągnięcia celu biznesowego jakiemu towarzyszy działanie serwerowni Infrastruktura Techniczna – to maszyny, urządzenia, systemy i instalacje techniczne, w szczególności systemy i instalacje elektroenergetyczne i teletechniczne oraz systemy i instalacje mechaniczne związane głównie z utrzymaniem właściwych parametrów środowiska pracy systemów informatycznych (wilgotność i temperatura), właściwych dla bezpiecznego użytkowania systemów IT, np. zgodnie z zaleceniami producentów lub niezależnych instytucji standaryzacyjnych np. ASHRAE (Amerykańskie Stowarzyszenie Inżynierów Ogrzewnictwa Chłodzenia i Klimatyzacji). Infrastruktura techniczna może być oparta o różne technologie, bardziej lub mniej przyjazne środowisku a także zarządzania w sposób sprzyjający minimalizujące zużycia energii, szczególnie jeśli serwerownia nie osiąga nominalnego (tzn. obliczeniowego) obciążenia (tzn. wykorzystania), czyli powierzchnia serwerowni jest niedociążona. W takim przypadku wskaźnik PUE może osiągać bardzo niezadowalające wyniki a koszty eksploatacji jednostkowo rosną. W przypadku eksploatacji serwerowni może istnieć wiele strategii regulacji powodujących minimalizowanie zużycie energii opartych o centralne systemy zarządzania i oprogramowanie klasy DCIM (Data Center Infrastructure Management). W zależności od obciążenia serwerowni oraz występujących warunków atmosferycznych strategie będą realizować algorytmy maksymalizacji wykorzystania freecolingu, czyli wykorzystania naturalnego potencjału środowiska do chłodzenia środowiska pracy systemów informatycznych przy minimalnym udziale systemów wytwarzania chłodu w sposób mechaniczny (sprężarkowy z wykorzystaniem cieczy niskowrzących oraz procesów termodynamicznych przekazujących ciepło ze źródeł o wyższej temperaturze do źródeł o niższej temperaturze).

Infrastruktura Techniczna – to maszyny, urządzenia, systemy i instalacje techniczne, w szczególności systemy i instalacje elektroenergetyczne i teletechniczne oraz systemy i instalacje mechaniczne związane głównie z utrzymaniem właściwych parametrów środowiska pracy systemów informatycznych (wilgotność i temperatura), właściwych dla bezpiecznego użytkowania systemów IT, np. zgodnie z zaleceniami producentów lub niezależnych instytucji standaryzacyjnych np. ASHRAE (Amerykańskie Stowarzyszenie Inżynierów Ogrzewnictwa Chłodzenia i Klimatyzacji). Infrastruktura techniczna może być oparta o różne technologie, bardziej lub mniej przyjazne środowisku a także zarządzania w sposób sprzyjający minimalizujące zużycia energii, szczególnie jeśli serwerownia nie osiąga nominalnego (tzn. obliczeniowego) obciążenia (tzn. wykorzystania), czyli powierzchnia serwerowni jest niedociążona. W takim przypadku wskaźnik PUE może osiągać bardzo niezadowalające wyniki a koszty eksploatacji jednostkowo rosną. W przypadku eksploatacji serwerowni może istnieć wiele strategii regulacji powodujących minimalizowanie zużycie energii opartych o centralne systemy zarządzania i oprogramowanie klasy DCIM (Data Center Infrastructure Management). W zależności od obciążenia serwerowni oraz występujących warunków atmosferycznych strategie będą realizować algorytmy maksymalizacji wykorzystania freecolingu, czyli wykorzystania naturalnego potencjału środowiska do chłodzenia środowiska pracy systemów informatycznych przy minimalnym udziale systemów wytwarzania chłodu w sposób mechaniczny (sprężarkowy z wykorzystaniem cieczy niskowrzących oraz procesów termodynamicznych przekazujących ciepło ze źródeł o wyższej temperaturze do źródeł o niższej temperaturze).

Koszty posiadania własnej infrastruktury (koszty posiadania Data Center)

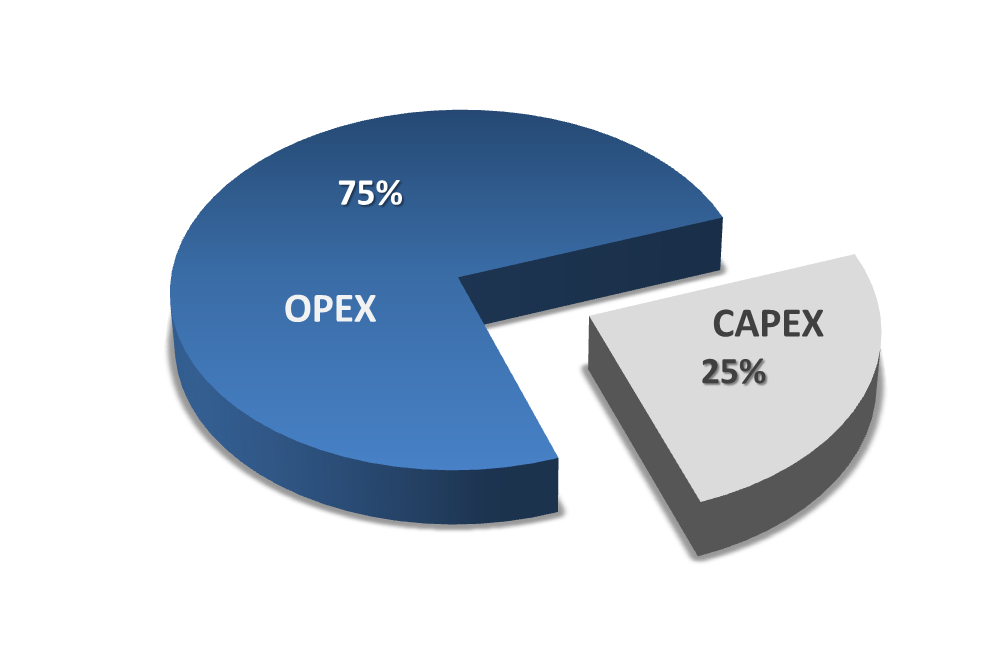

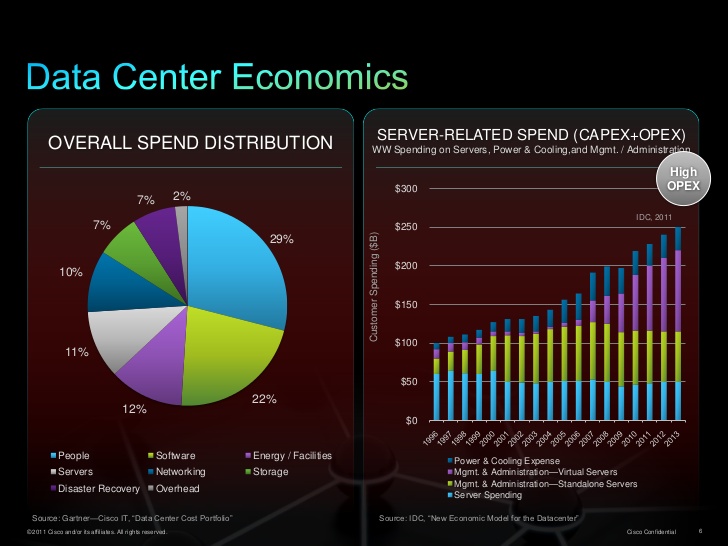

W przypadku Klientów biznesowych, użytkujących do tej pory własną infrastrukturę IT, najczęstszym powodem tych zmian są koszty, które można podzielić na koszty inwestycyjne (CAPEX – Capital Expences) – związany z budową infrastruktury lub wymianami wymuszonymi przez postęp technologiczny, i koszty utrzymania (OPEX – Operating Expences), przy czym większość wydatków jest jednak związana z bieżącym utrzymaniem infrastruktury i dostępu do jej usług.

Na wielkość OPEX największy wpływ ma koszt i ilość zużywanej energii. W roku 2010 serwerownie zużywały 1,1-1,5% światowej produkcji energii, a w ostatnich latach roczny trend wzrostowy notował średnio 7% (a regionalnie nawet 30%) wzrostu zużycia energii przez IT. Obecnie, szacuje się, że serwerownie odpowiadają za zużycie około 3%, a cała branża IT i Telecom za zużycie około 11% światowej produkcji energii elektrycznej wynoszącej obecnie około 25 000 TWh. Prognozy zakładają także, że w następnej dekadzie zużycie energii przez branże IT zostanie potrojone. Intensywnie eksploatowany „smartfon” zużywa rocznie porównywalnie tyle energii jak mała domowa lodówka, co więcej, za usługami związanymi z „smart” telefonu komórkowego kryją się inne węzły infrastruktury technicznej zużywające gigantyczne ilości energii.

Bezpieczeństwo danych, ciągły dostęp do usług

W związku z powszechnym zastosowaniem informatyki i przetwarzania danych we wszystkich aspektach życia społecznego, aktywności gospodarczej oraz administracji publicznej, zapewnienie ciągłego dostępu do usług biznesowych serwerowni a także bezpieczeństwo danych stało się krytyczne. Dostosowanie infrastruktury do wymagań wysokiej niezawodności i dostępności danych stało się nową dziedziną techniki podlegającą procesowi kwalifikacji i certyfikacji. Na rynku amerykańskim zostały zawiązane komercyjne ciała doradcze, np. Uptme Institute, Building Industry Consulting Service International (BICSI) oraz normalizacyjne, Telecommunications Industry Association (TIA). W 2016 Europejski Komitet Normalizacyjny Elektrotechniki (CENELEC) zakończył etap prac polegający na stworzeniu grupy norm EN 50600 „Data Centre Infrastructure and Facilities”. Jest to obszerna, w zasadzie pierwsza na świecie, seria dokumentów normalizacyjnych obejmujących w pełni wszystkie aspekty funkcjonowania centrów przetwarzania danych pod kątem wymogów infrastrukturalnych. Zawiera zarówno elementy klasyfikacji niezawodności, metody projektowania jak również elementy opisujące właściwą eksploatację ja też zapewnienie efektywności energetycznej. Normy te doskonale współgrają z opracowaniami normalizacyjnymi takimi jak ISO/IEC 20000 (zarządzanie usługami IT), ISO/IEC 27001 opisującej wymogi bezpieczeństwa informacji i ciągłości przetwarzania (ISO 22301).

Dzisiejsze centra przetwarzania danych w zakresie zapewnienia niezawodnej pracy urządzeń IT cechuje przede wszystkim bezpieczeństwo (określenie jako dostępność lub niezawodność) oparte o rozwiązania techniczne (głównie wielowymiarową redundancje urządzeń i systemów infrastruktury oraz bezpieczeństwo i ciągłość zasilania i chłodzenia) oraz restrykcyjne procedury związane z kompetencjami personelu, procedurami eksploatacyjnymi oraz remontowymi a także procedury wprowadzania zmian. Lokalizacja serwerowni jest starannie rozpatrywana, nie tylko pod względem dostępności do mediów, dostępności do pasma, odległości wpływającej na notowane w aplikacjach opóźnienia, ale także ze względu na fizyczne bezpieczeństwo danych.

Realia rynku polskiego

Polski rynek usług Data Center jest głównie nastawiony na:

• usługi dostępu do infrastruktury ICT (technologie informacyjno-komunikacyjne)

• usługi zarządzania infrastrukturą

• usługi zarządzania i udostępniania oprogramowania

• usługi dodane i outsourcing

Na polskim rynku wciąż obserwuje się stosunkowo niskie nasycenie przy jednoczesnej dużej dynamice wzrostu i rozwoju z czego największe nasycenie wykazuje Województwo Mazowieckie. Szacuje się, że w Polsce obecnie jest około 100 000 – 120 000 m2 powierzchni komór serwerowych netto łącznie, przy czym większość serwerowni ma powierzchnię poniżej 100 m2 i jednocześnie powstał do tej pory jeden obiekt (2016) o powierzchni netto komór razem większej niż 4000 m2. Obserwowana dynamika wzrostu rynku podaży Data Center wyniosła 2014 roku 11,1% (YTY) a w 2015 roku 10,3% (YTY) a stopa zwrotu kapitału zainwestowanego w serwerownie ma tendencje spadkową. Prognozuje się dalszy spadek dynamiki przyrostu powierzchni kolokacyjnej do 6.7% do roku 2021. Powodem tego jest trend obniżania cen usług kolokacji obserwowany od roku 2013. Wciąż nie zagospodarowane pozostaje około 1/3 powierzchni netto powierzchni przeznaczonej na usługi kolokacji. Cena kolokacji pojedynczej szary RACK na przestrzeni lat 2014-2016 spadła średnio o 237 złotych netto.

Analizując wielkość dostępnej komercyjnej powierzchni kolokacyjnej w serwerowniach, należy zauważyć że według analizy rynku na rok 2015 łączna powierzchnia komór serwerowych przekroczyła 55 tysięcy m2, z tendencją rocznego przyrostu rzędu 3-5 tysięcy m2 notowanej na przestrzeni ostatnich 7 lat.

Szacuje się również, że w 2015 zajętość dostępnej powierzchni komercyjnych centrów danych sięgnęła 60%, przy czym analiza dotyczy obiektów o powierzchni powyżej 500 m2 powierzchni komory, których jest w Polsce w roku 2016 było łącznie 86 obiektów.

Należy także odnotować duże rozdrobnienie obiektów. W roku 2015 serwerowni komercyjnych posiadających łącznie powyżej 1000 m2 powierzchni było jedynie 14 obiektów.

Należy jednocześnie odnotować zwiększające się zainteresowanie światowych potentatów rynkiem polskim kolokacji czy usług w „chmurze”. Świadczy o tym m-in. kapitałowe przejęcia rodzimych firm przez światowych potentatów. Przykładem jest przejęcie firmy lokalnej firmy PLIX przez Telecity a następnie przez Equinix czy poszukiwanie strategicznego Inwestora przez ATMan po nieudanej próbie przejęcia przez fundusz inwestycyjny Innova Capital. W 2015 roku 17 procent wszystkich danych było przetwarzanych we własnych serwerowniach (wirtualne lub zarządzane w ramach prywatnej chmury) – wzrost o1,4% w stosunku do roku 2014. Tymczasem 10,4 procent wszystkich RACK zostało „outsorsowane” w chmurze. Oznacza wzrost o 0,8% w stosunku do roku 2014. Obecnie wartość rynku usług Data Center jest szacowana na 1,15 mld zł (z czego 390 mln kolokacje), Prognoza wzrostu rynku szacuje wzrost usług Data Center do roku 2018 do poziomu około ~ 2 mld zł.

Szansą dla pomyślnego zainwestowania pieniędzy Skarbu państwa w rynek Data Center jest Strategia "Sprawne Państwo 2020„ - podniesienie sprawności i efektywności działania administracji publicznej na rzecz obywatela i szeroką z nim współpracę - przy wykorzystaniu nowoczesnych technologii informacyjno-komunikacyjnych (m.in. sprawną komunikacją i wymianą dokumentów) mające na celu:

Szansą dla pomyślnego zainwestowania pieniędzy Skarbu państwa w rynek Data Center jest Strategia "Sprawne Państwo 2020„ - podniesienie sprawności i efektywności działania administracji publicznej na rzecz obywatela i szeroką z nim współpracę - przy wykorzystaniu nowoczesnych technologii informacyjno-komunikacyjnych (m.in. sprawną komunikacją i wymianą dokumentów) mające na celu:

o zwiększeni konkurencyjności i innowacyjności gospodarki,

o zwiększenie efektywności i sprawności państwa,

o wyrównywanie różnic w poziomie rozwoju województw.

Strategia informatyzacji i wyrównywania szans w dobie społeczeństwa cyfrowego została przełożona na szereg strategii operacyjnych do których należą m.in.:

• Strategia innowacyjności i efektywności gospodarki (Ministerstwo Gospodarki),

• Strategia rozwoju kapitału ludzkiego (Ministerstwo Pracy i Polityki Społecznej),

• Strategia rozwoju transportu (Ministerstwo Infrastruktury i Rozwoju),

• Strategia Bezpieczeństwo energetyczne i środowisko (Ministerstwo Gospodarki),

• Strategia Sprawne państwo (Ministerstwo Administracji i Cyfryzacji),

• Strategia rozwoju kapitału społecznego (Ministerstwo Kultury i Dziedzictwa Narodowego),

• Krajowa strategia rozwoju regionalnego - miasta i obszary wiejskie (Ministerstwo Infrastruktury i Rozwoju),

• Strategia zrównoważonego rozwoju wsi, rolnictwa i rybactwa (Ministerstwo Rolnictwa i Rozwoju Wsi),

• Strategia rozwoju systemu bezpieczeństwa narodowego RP (Ministerstwo Obrony Narodowej).

a także programy operacyjne, m.in.:

• Program Operacyjny „Innowacyjna Gospodarka”

• Program Operacyjny „e-administracja” – jeden priorytetów Unii Europejskiej w sferze cyfrowej - zasada jednorazowego pobierania danych przez administrację tj. zapewnienie, że administracja publiczna wykorzystuje wielokrotnie informacje o obywatelu lub przedsiębiorstwie, które są już do jej dyspozycji.

• Program rozwoju sieci i usług telekomunikacyjnych.

• Program e-zdrowie (cyfryzacja danych medycznych – do 2017 roku)

Wszystkie te programy i strategie generują duże potrzeby Państwa w zakresie budowy i utrzymania ruchu Data Center. Według analiz rynku serwerowni w Polsce, Administracja Państwowa jest jednym z głównych motorów powstawania nowych obiektów. Obserwowany obecnie trend ciągłego wzrostu agregowanych, przetwarzanych i przechowywanych danych jak również przenoszenie zasobów do „chmury obliczeniowej” będzie przyczyniał się do zwiększania zapotrzebowania na dostęp do nowoczesnej infrastruktury IT lokowanej w serwerowniach. Szacuje się, że w 2015 roku jedynie 13% zasobów Administracji Publicznej oraz 8% Administracji Samorządowej było kolokowanych. Tak więc potrzeby te są jedynie częściowo zaspokajane przez usługodawców oferujących usługi kolokacji. Jak wynika z informacji przekazywanych przez Ministerstwo Cyfryzacji potrzeby Państwa w tym zakresie są nadal ogromne, i co więcej w opinii rządzących - są zaniedbane. Cytat. „Niedawna awaria ePUAP przypomniała nam wszystkim, że w Polsce jest pewien poważny problem z informatyzacją administracji publicznej. Systemy stworzone za miliony złotych mogą służyć tylko tysiącom, setkom, a czasem nawet tylko dziesiątkom obywateli. Co gorsza, te systemy są mocno zawodne toteż nic dziwnego, że wielu Polaków nadal preferuje osobisty kontakt z urzędnikiem. Wciąż wielu z nas nie wierzy, że da się załatwiać sprawy w urzędzie przez Internet” oraz „Na ironię zakrawa fakt, że dokument „Program Zintegrowanej Informatyzacji Państwa” przyjęty został przez Radę Ministrów 8 stycznia 2014r., a więc po już po zakończeniu perspektywy budżetowej 2007-2013, (...) i po rozpoczęciu wydatkowania środków we wszystkich projektach informatycznych finansowanych z osi 7 POIG, co spowodowało, że dokument ten miał wartość jedynie deklaratywną (zbiór pobożnych życzeń oraz wskazówek jak nie należy informatyzować administracji publicznej)”

W roku 2012, gdy powstało pierwsze ministerstwo cyfryzacji, ówczesny rząd zapowiadał uporządkowanie "stajni augiasza". Niestety jak ocenia to nowy rząd, nie udało się tego zrobić, a teraz przed tym zadaniem stoi kolejna osoba - minister Anna Streżyńska. W wystąpieniu Pani minister podaje liczby:

• 4 miliardy złotych - tyle przeznaczono na realizację projektów z zakresu budowy elektronicznej administracji.

• 3,4 mld złotych pochodziło ze środków UE.

• 600 mln złotych wynosił wkład krajowy, a więc tyle daliśmy na to wszyscy.

Dodatkowo można przytoczyć następujące słowa Pani minister:

Dodatkowo można przytoczyć następujące słowa Pani minister:

” Jeżeli ktoś zajmuje się informatyzacją w sektorze publicznym, musi być przygotowany na to, że jego chlebem codziennym będą oskarżenia o przekręty. Nawet jeżeli będzie uczciwy. Dzisiaj połowa tych zasobów, które zbudowano za pieniądze z poprzedniej unijnej perspektywy budżetowej, stoi niewykorzystana, podczas gdy wnioski do nowego programu operacyjnego Polska Cyfrowa, które do mnie trafiły, czterokrotnie przewyższają to, co jest do dyspozycji. I proszę sobie wyobrazić, że prawie w każdym z nich jest mowa o budowie serwerowni.”

Pani minister stwierdziła również, że Państwo nie wykorzystuje efektu skali „…brak możliwości wykorzystania efektu skali i uzyskania oszczędności przy nabywaniu urządzeń i technologii IT, pomijanie przez resorty efektów wdrożeń w innych resortach, brak poszukiwania efektów synergii w skali całej administracji publicznej. W efekcie środki publiczne były wydawane chaotycznie i w sposób daleki od efektywności".

Podsumowanie i wnioski

Wspomniany efekt skali jest w przypadku centrów przetwarzania danych wart szczególnej uwagi. Państwo przetwarza olbrzymie ilości danych w celu zaspokajania potrzeb obywateli jak również na potrzeby własne i swojego bezpieczeństwa. Wymaga to wielkich zasobów infrastruktury centrów danych. Wydaje się bezdyskusyjne, że w tym wypadku efekt skali powinien zostać wykorzystany do prowadzenia jednolitej oraz scentralizowanej polityki w zakresie potrzeb IT w skali Państwa. Inną zupełnie kwestią jest ciągły rozwój podaży powierzchni kolokacyjnej oraz usług "cloudowych".

Zapraszamy do dyskusji.

Autorzy:

mgr inż. Krzysztof Szczygieł.

mgr inż. Inż. Paweł Wróbel